在生命诞生初期,生命体是非常简单的。它们是微小的单细胞生物,几乎没有协调能力。然而,经过数十亿年的竞争和自然选择,这些简单的生命体逐渐演化成为我们今天所拥有的复杂生命形式以及复杂的人类智慧。

总部位于旧金山的营利性AI实验室“OpenAI”的研究人员现在正在验证这样一个假设:如果可以在虚拟世界中模拟这种竞争,是否能够演化出更加复杂的人工智能呢?

近期,OpenAI的实验智能体逐渐具备了掌握复杂行为的能力,为开发更复杂的人工智能指引了一条新的道路。

该实验基于该领域现有的两种思想:多智能体学习,即通过将多种算法进行竞争或协调以产生应急智能;以及强化学习,即一种在不断试验和纠错的过程中学习并实现目标的特定机器学习技术。

DeepMind凭借其具有突破性的程序AlphaGo,击败了围棋中最优秀的人类棋手,从而很好地普及了强化学习这一概念。

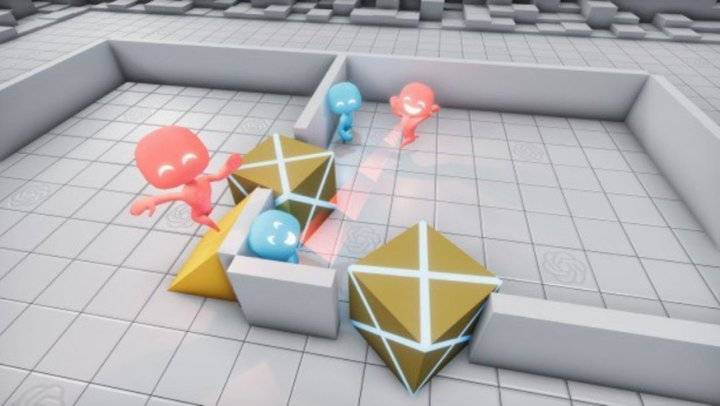

在最近发布的一篇论文中,OpenAI揭示了这一试验的初步结果。在玩了数亿次捉迷藏游戏后,两个相互竞争的AI队伍(搜寻者和躲藏者)设计出了复杂的游戏策略,其中不乏工具使用和相互协作。该研究也是对以OpenAI为主导的研究策略的深刻诠释:大幅扩展现有的人工智能技术,看看有没有什么新东西出现。

论文链接:

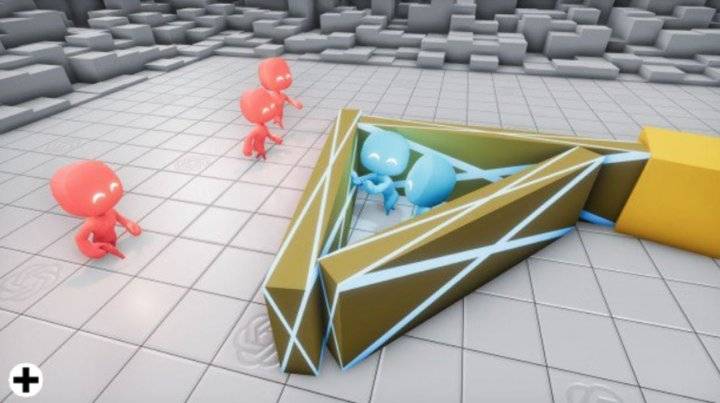

到第三阶段,搜寻者学会了使用坡道爬过堡垒的墙壁。

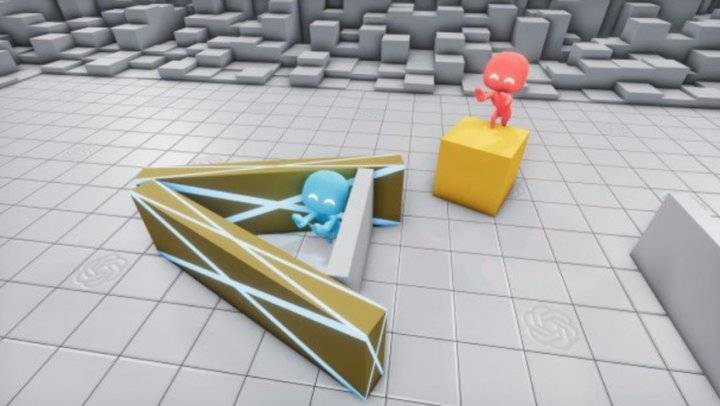

最终,在经过3.8亿轮训练后,搜寻者学会了以“箱顶冲浪”来越过堡垒的城墙。

新型复杂智能的可能性

研究人员认为,这些结果初步验证了这一创造复杂AI的新方法的可行性。该论文的作者之一Bowen Baker说:“我们没有告诉AI玩家在箱子附近奔跑或与它进行互动,但是通过多智能体竞争,他们为彼此创建了新任务,一支团队必须想出新的策略来战胜另一支团队。”

这项研究反映了OpenAI独特的AI研究方法。尽管该实验室和其他实验室一样也投资开发了其他的新颖技术,但它主要还是以扩展现有技术的使用而广为人知。例如,实验室“臭名昭著”的语言模型 GPT-2,就借用了早期语言模型(包括Google的BERT)中大量的算法设计;OpenAI的创新基于其工程设计和庞大的计算资源。

https://technologyreview.com/s/612960/an-ai-tool-auto-generates-fake-news-bogus-tweets-and-plenty-of-gibberish/

(大数据文摘出品,来源:technologyreview)

找记者、求报道、求帮助,各大应用市场下载“齐鲁壹点”APP或搜索微信小程序“壹点情报站”,全省600多位主流媒体记者在线等你来报料!

设为首页

设为首页